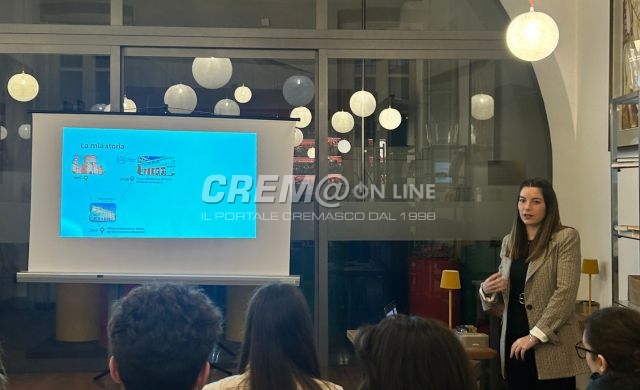

Il sistema visivo rappresenta un sistema complesso di fondamentale importanza: l’essere umano utilizza la vista più degli altri sensi per potersi orientare nell’ambiente che lo circonda e raccogliere da esso le informazioni sulla realtà. Cosa accadrebbe se potessimo insegnare all’intelligenza artificiale a fare lo stesso, ovvero se l’Ai potesse apprendere dai video, non solo riconoscendo oggetti e persone, ma capendo il contesto, prevedendo azioni e persino deducendo cause ed effetti? A questa domanda ha risposto Chiara Plizzari, ricercatrice per il Politecnico di Milano presso lo Smart Eyewer Lab. Nell’ambito del progetto Girls in Stem promosso dall’assessorato alle pari opportunità del comune di Crema, l’associazione Ipàzia ha organizzato, presso il caffè del museo, l’aperitivo scientifico “Come l’Ai impara dai video”.

Alla scoperta della computer vision

Nello specifico, Chiara Plizzari, si è focalizzata sulla computer vision, un campo specifico dell’intelligenza artificiale che permette ai pc di ricavare informazioni da immagini, video e altri input. Per poter funzionare correttamente, i sistemi di visione artificiale hanno bisogno di essere addestrati con una grande quantità di immagini. Tali immagini, opportunamente etichettate, andranno a costituire il dataset che potrà rendere l’algoritmo realmente intelligente. La computer visione viene spesso usata con Google Lens, ma lo possiamo trovare applicata in diversi ambiti. Si passa dal riconoscimento degli oggetti, alla medicina, fino alla smart surveillance (videocamere di sorveglianza intelligenti o in cloud per analizzare le immagini registrate e identificare infrazioni).